如果 AI 无法说出上海话,它是否也无法真正“理解”人类?本文以 Sora 的语言生成缺陷为切口,试图揭示技术与文化之间的张力,并探讨我们为何越靠近边界,越能看清智能的本质。

一、起因

国庆假期之前,有人提议试试Sora2是否可以说上海方言,于是我们设想让Sora2生成一段视频,画面里 Sama 用上海话说一句中秋祝福。 实验结果是,视频生成流畅,但说的不是上海话。改了很多prompt强调,也没能让它成功。偶尔会有某个沪语蹦出来,却无法“生成语言系统”。那一刻,我们看见了AI理解世界的“缺口”。

二、为什么Sora说不出上海话?

数据 / 语料稀缺

AI 模型的语音模块主要训练于普通话/英语语料。而高质量、带时间标注的上海话语料极少。

音系 / 发音系统差异

吴语与普通话音系不同。模型可以在一个音系中“模仿口音”,却难以无监督地“学会”另一套音位系统。

唇形映射缺口

Sora 的视频生成依赖语音与口型的对齐。普通话有完整映射模型,而方言没有。所以即便模型“合成”出声音,也会嘴型不对。

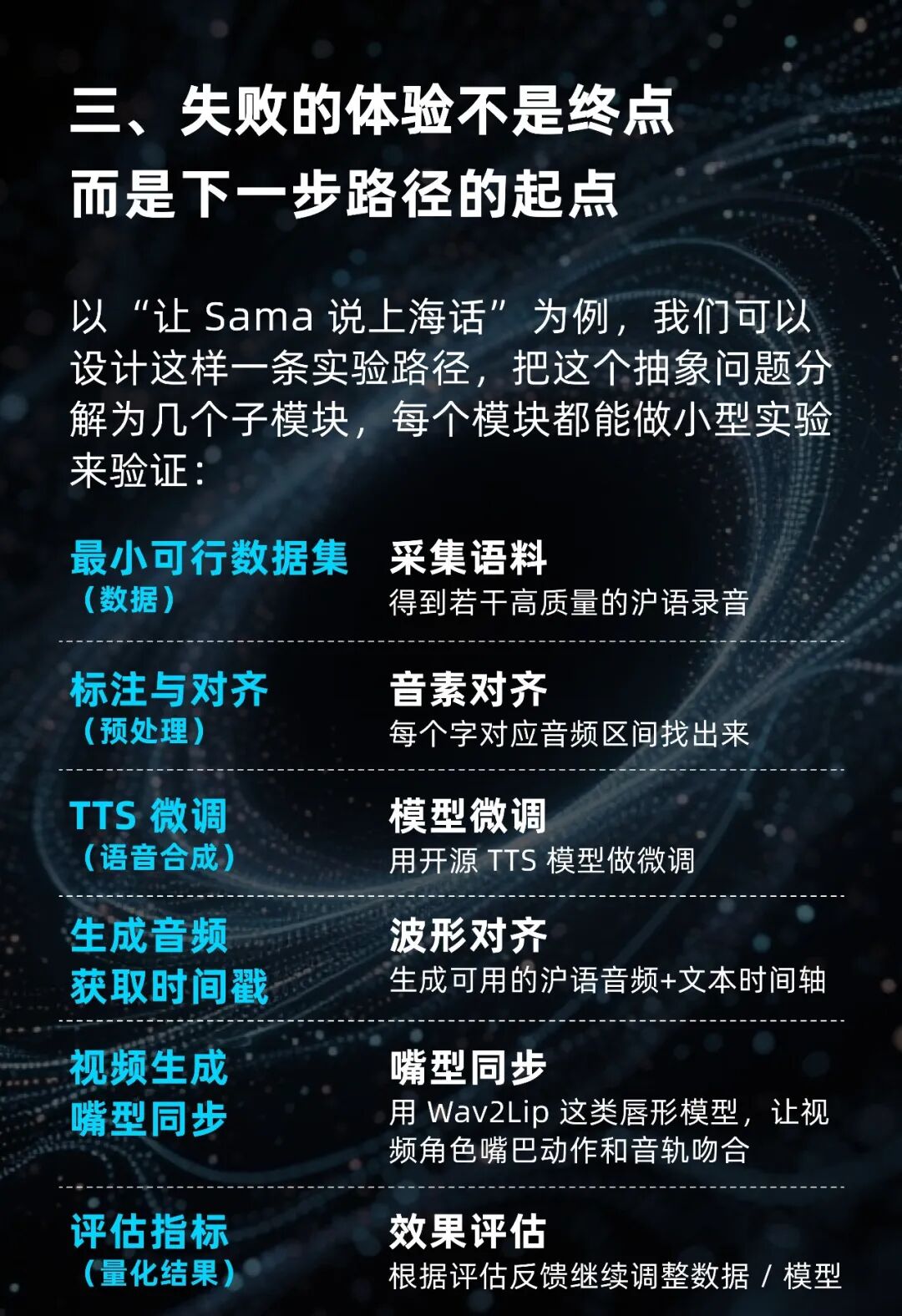

三、失败的体验不是终点,而是下一步路径的起点

以 “让 Sama 说上海话” 为例,我们可以设计这样一条实验路径,把这个抽象问题分解为几个子模块,每个模块都能做小型实验来验证:

1. 最小可行数据集(数据)

采集语料,得到若干高质量的沪语录音。

量级建议:30–120分钟高质量沪语录音(单说话人或多说话人),采样率 16k–24k,逐句分文件并带人工转写(汉字 + 上海话音标或 IPA)。工具:录音棚或高质量手机+降噪;Whisper 可做初版转写,再人工校对。

2.标注与对齐(预处理)

音素对齐:每个字对应音频区间找出来。用Montreal Forced Aligner (MFA)或 Gentle 做音素级对齐,输出 TextGrid / .lab。建立 G2P 映射:汉字→上海话拼写(或直接用 IPA),保证 TTS 能接收正确音位序列。

3.TTS 微调(语音合成)

模型微调:用开源 TTS 模型做微调

方案一(开源):用VITS / PaddleSpeech / ESPnet微调模型(用 30–120min 数据即可做 voice cloning 基线)。方案二(商用快速):评估是否可用第三方 TTS(已有厂商开始支持方言),作为短期替代。

4.生成音频并获取时间戳

波形对齐:生成可用的沪语音频+文本时间轴。

用 TTS 输出 wav + phoneme alignment(如果 VITS 不直接输出 alignment,使用 MFA 重新对齐)。

5.视频生成与嘴型同步

Sora 生成无声视频 → 用 Wav2Lip/SadTalker 替换嘴型并合成音轨,让视频角色嘴巴动作和音轨吻合6. 评估指标(量化好奇结果)效果评估,根据评估反馈继续调整数据 / 模型主观:MOS(1–5)≥ 3.5(10 人盲测)

客观语音:Phone Error Rate(PER)或方言版 WER ≤ 15%

唇形同步:平均口唇延迟 ≤ 0.1s;viseme match ratio ≥ 85%

文化自然度:专家打分(本地母语者)≥ 4/5

四、从AI“失败”中发现:好奇不只是提问,而是把问题拆成工程任务的能力

好奇的第一步,发现差异

例如Sama 没说出上海话

第二步,把差异拆解成可测的子问题

数据覆盖、音位表、对齐、唇形同步

第三步,设计实验

数据采集、微调TTS、唇形映射、整合测试

第四步,迭代与量化

MOS、音素错误率、viseme sync score

这就是“工程化好奇(Curiosity Engineering)”的核心:把问题拆成实验、把直觉变成路径。

五、最纯粹的科学逻辑

后来,我们换了个实验。让Sora2生成一个“爱因斯坦赏月”的视频。

在视频里,AI生成的爱因斯坦咬着月饼,微笑着说:

“我咬这一口,只是想知道,这味道从何而来。”

看似浪漫,其实是最纯粹的科学逻辑:疑问 → 假设 → 实验 → 验证 → 再提问。

AI今天能模拟这个过程,

但仍然缺少第一步的“为什么”。

那是人类独有的好奇机制。

六、结语:好奇,是AI与人类共演的起点

AI的极限,不在算力,而在提问的想象力。

当AI“不会”某件事时,不是失败,而是人类好奇的入口。

Sora无法生成方言的“沉默”,提醒我们去追问:

我们能否让AI学会的不仅是语言,还有理解?

能否用“工程化的好奇”,让AI和人类一起实验未知?

在一个被算法主导、预测不断增强的时代,好奇是人类最后的开放接口。

心理学上,好奇被定义为:

“在不确定中寻求模式的驱动力。”

神经科学研究表明,当我们面对未知时,大脑的奖赏系统会被激活,多巴胺释放,让我们保持探索的愉悦。

而在 AI 时代,我们越是被“已知”包围,就越需要一种方法,重新发明“不知道”的乐趣。

作者:好奇设