你是否也在用AI时感到“它越来越强,却越来越难用”?本文将带你从2025年AI报告出发,拆解AI能力的最新升级路径,从多模态输入、任务分解到角色扮演,一步步教你如何打造“能听懂、能协同、能表达”的AI助理,让你的工作真正“提效不添乱”。

年初爆火的Reasoning

毫无疑问,在Sora 2之后,AI领域的战火彻底烧到了“思考”这块高地。

最新的《2025年AI现状报告》向我们展示了一个极为清晰的画面:这场竞争正以一种让人眼花缭乱的速度,围绕着模型的“推理”(Reasoning)能力展开,推理能力的扩展性如今成为了新的能力护城河。多说无益,我们直接来看报告中揭示的,AI在能力上究竟跑出了哪些最新效果。

一切始于对“思考”的追逐。

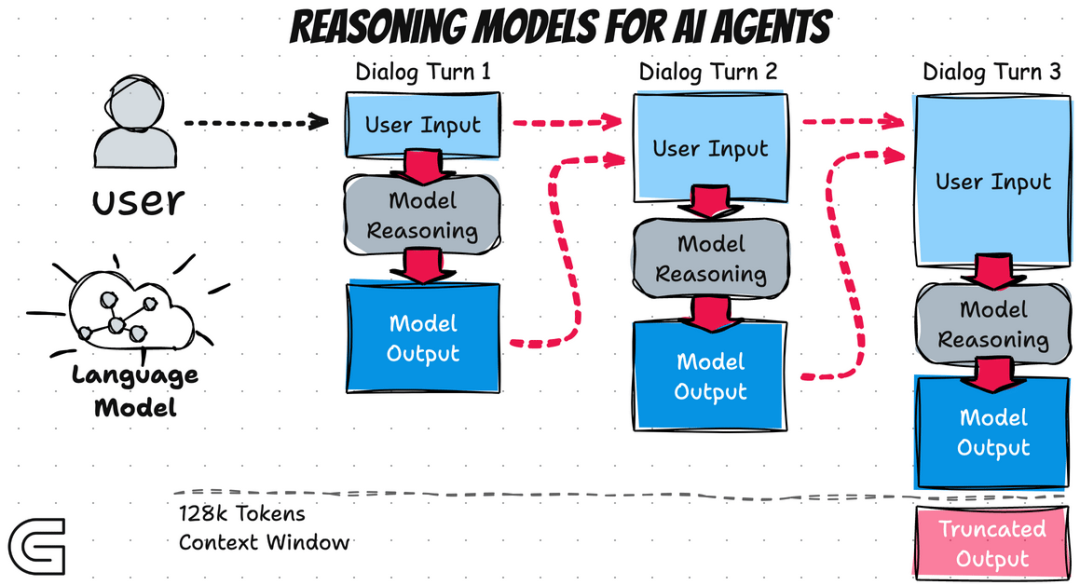

OpenAI 的 o1 模型(o1-preview)首次向业界展示了通过强化学习(RL)来扩展推理能力的潜力,它将思维链(CoT)用作草稿板,使得在代码和科学等推理密集型领域的问题解决能力得到增强。

报告指出,o1模型通过强化学习和可验证奖励引入了更严格的推理过程,允许代理在结构化环境中处理长时间任务。

但紧随其后,一场来自东方的挑战迅速颠覆了格局。

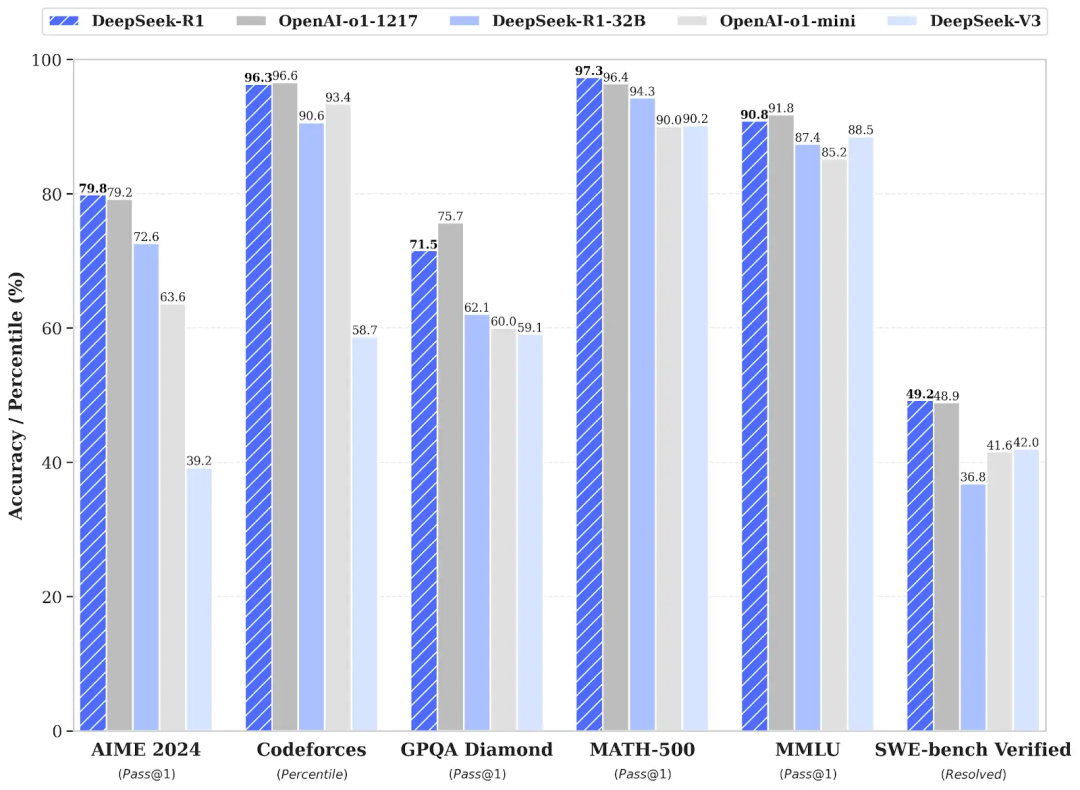

来自 DeepSeek 的 R1-lite-preview 模型,在 AIME 2024 pass@1 基准测试上直接超越了 o1-preview。

这份能力飞跃,部分源于其 R1-Zero 模型仅使用可验证奖励(verifiable rewards)进行 RL 训练的创新,这种方法使得模型能够更专注于正确的推理路径。

如今,模型甚至学会了“分岔思考”,即通过自适应并行推理 (APR) 动态协调多条推理路径,聚合出一个更连贯的答案,这能有效减少幻觉。

更有研究开始探索利用 LLM 的内部残差流进行推理(例如 COCONUT),无需生成语言令牌,这能大幅减少推理时的计算资源。

报告还强调,中国模型如DeepSeek、Qwen和Kimi在推理和编码基准上缩小了与OpenAI的差距,确立了中国作为全球AI第二的地位。

AI的进步是误判?

当大家细究这些推理增益的脉络时,报告里也提出了一个尖锐的警告:观察到的改进可能完全在基线模型的误差范围内,进步也许只是镜花水月。

更令人啼笑皆非的是,如果在数学问题中加入一句无关的干扰事实,SOTA推理模型的错误率竟然能增加高达7倍!这强烈暗示了模型做的更像是一种模板匹配,而非真正的代数逻辑,尤其是当其数字实例化发生变化时,准确率会急剧下降。

报告中提到,简单干扰事实对推理有巨大影响,而小变化会导致大失败,表明推理增益可能被夸大。基准测试也面临污染和变异问题,但代理、世界模型和领域工具(如代码、科学、医学)真正变得有用起来。

多模态的疯狂生长

模型的视觉与行动能力迎来了本质上的跃迁。

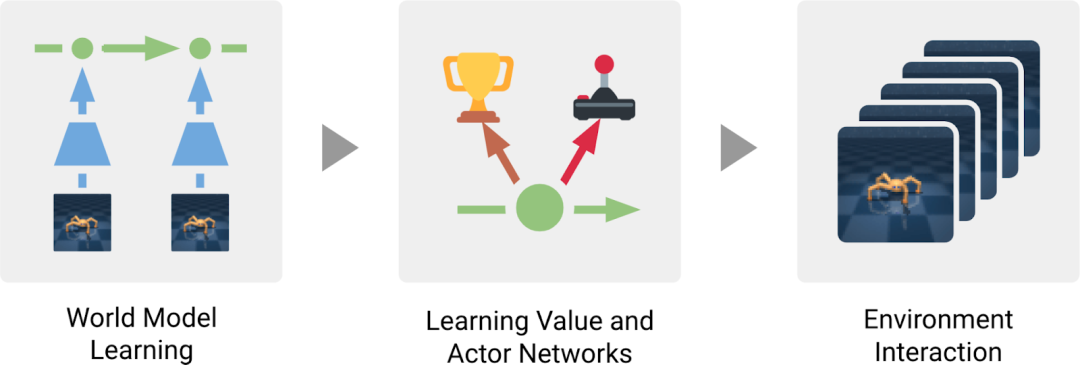

如果说此前的视频模型(如 Sora、Gen-3)只能生成固定的片段,你无法中途控制,那么现在的焦点已经完全转向了世界模型 (World model),这类系统能够基于用户的动作预测下一个状态,从而实现了闭环的实时交互性和分钟级的连贯性。例如,Google DeepMind 的 Dreamer 4 训练了一个视频世界模型,其策略完全是在“想象”中学习,并且在单个 GPU 上以实时帧率运行。

OpenAI 的Sora 2也全面升级,增加了同步对话和声音、更强的物理效果,并能够对多镜头场景进行更紧密的控制。

它甚至展示了一种新的能力:通过生成一个教授举起答案字母的视频,它能够“解决”文本基准问题,这表明了其惊人的视觉框架推理能力。

报告强调,世界模型从剪辑走向实时互动视频,Odyssey的公共预览每40ms流式传输新帧,支持5+分钟会话,用户可自由探索。

伴随着这一转变,具身智能也正在摆脱对昂贵标注数据的依赖。

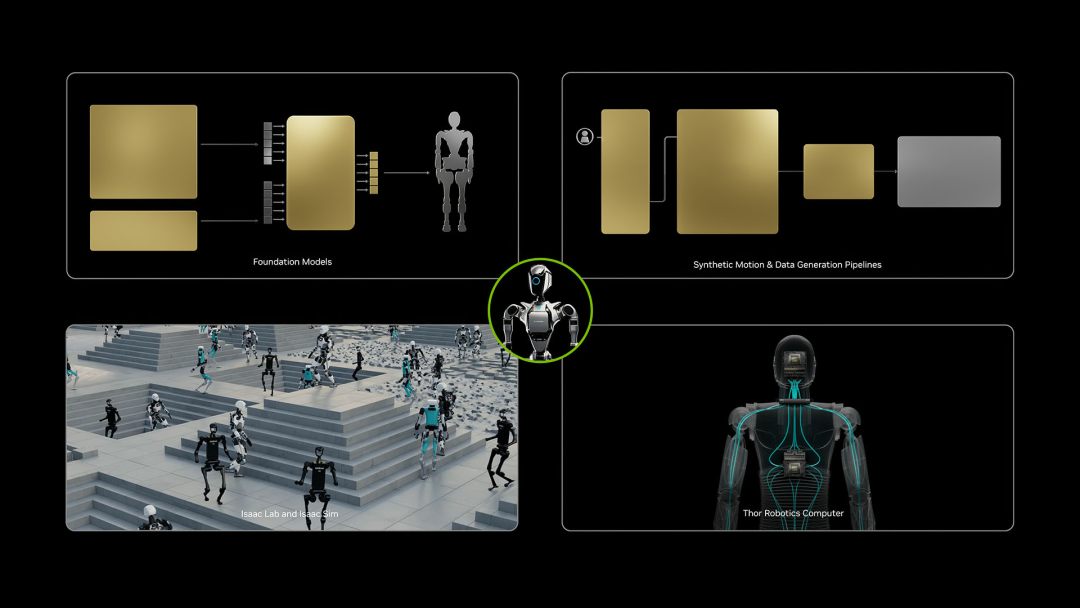

新一代的机器人智能体,如 NVIDIA 的 GR00T 1.5,正在利用神经渲染技术直接从非结构化的现实世界视频中构建隐式 3D 场景表示,大幅提高了数据效率。

在具身智能的架构上,出现了“行动链”(Chain-of-Action, CoA)的模式,这要求模型在执行低级控制之前先明确发出中间视觉或几何规划,以此提高了复杂操作的可靠性。

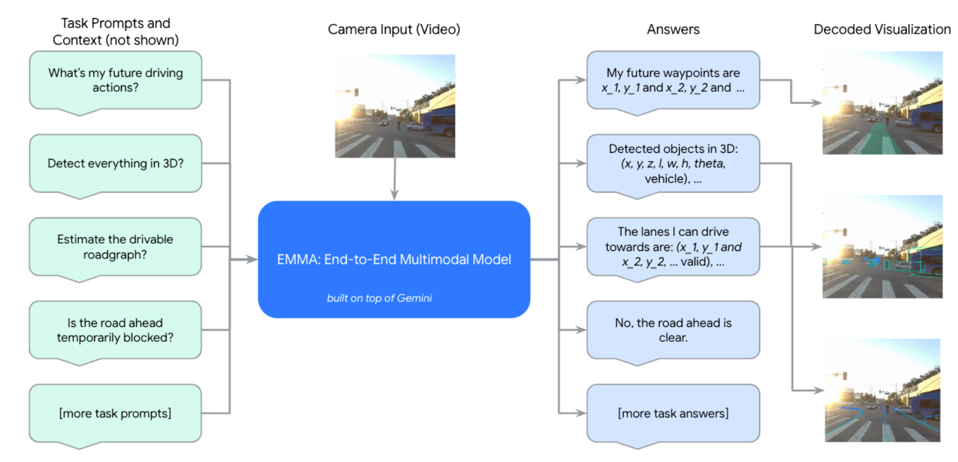

这种模式在 Waymo 的 EMMA 模型中得到了体现,该模型将自动驾驶重新定义为一个统一的视觉-语言问题,通过 CoT 推理提供了人类可读的决策理由。

报告指出,机器人整合推理通过Chain-of-Action规划,AI2的Molmo-Act和Gemini Robotics等是关键示例。

遍地开花

这种突破的势头也蔓延到了科学领域。AI不再仅仅充当辅助工具,而是转变为协作发现者。

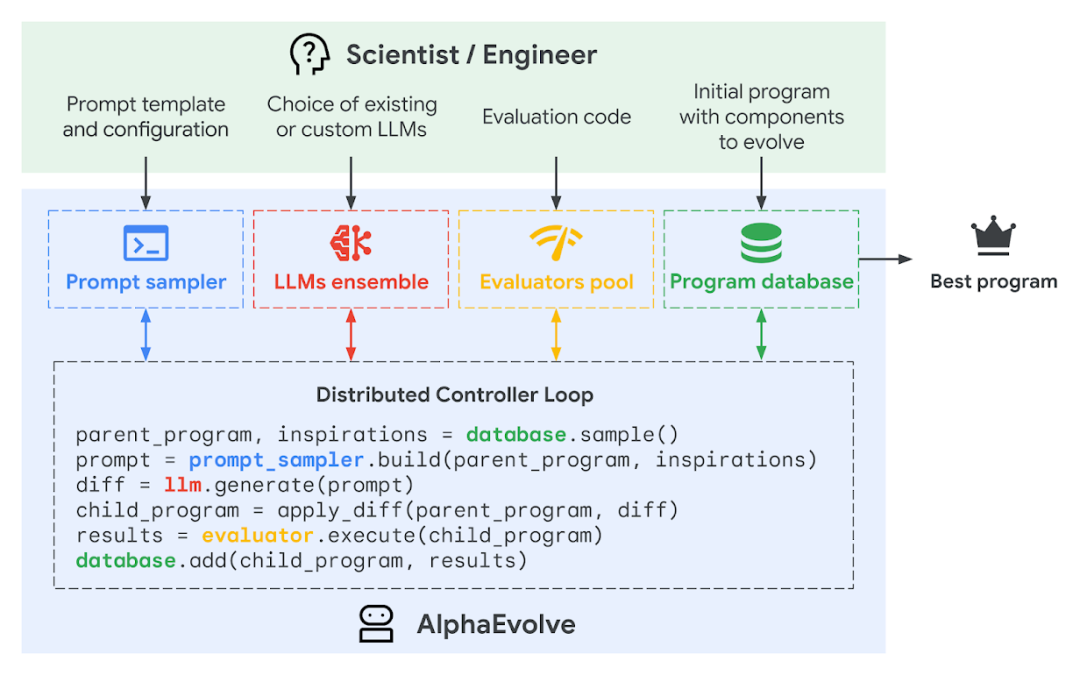

数学领域,OpenAI、DeepMind 和 Harmonic 都实现了IMO(国际数学奥林匹克竞赛)金牌级别的性能。DeepMind 的 AlphaEvolve 这个进化编码智能体,通过迭代编辑和自动化评估,竟然发现了一种新的矩阵乘法算法,比 Strassen 1969年的算法有所改进。这提供了 AI 系统能够独立产生可验证且超越人类的科学知识的具体例证。

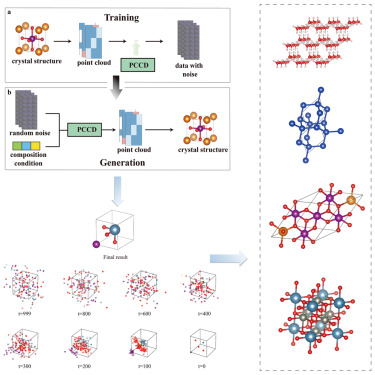

在材料科学上,Meta’s FAIR 训练了通用原子模型(UMA),它能快速准确地模拟材料、分子和吸附剂,替代了资源密集型的量子计算。MatterGen 扩散模型甚至能够直接根据目标特性(例如带隙和磁性)生成新型无机晶体。报告中,AI作为科学合作者,DeepMind的Co-Scientist和Stanford的Virtual Lab自主生成、测试和验证假设。

在生物学中,Profluent的ProGen3在1.5T标记上训练,建立蛋白质语言模型的计算前沿。

支撑所有这些能力增长的,是底层架构效率和优化技术的静默革命。

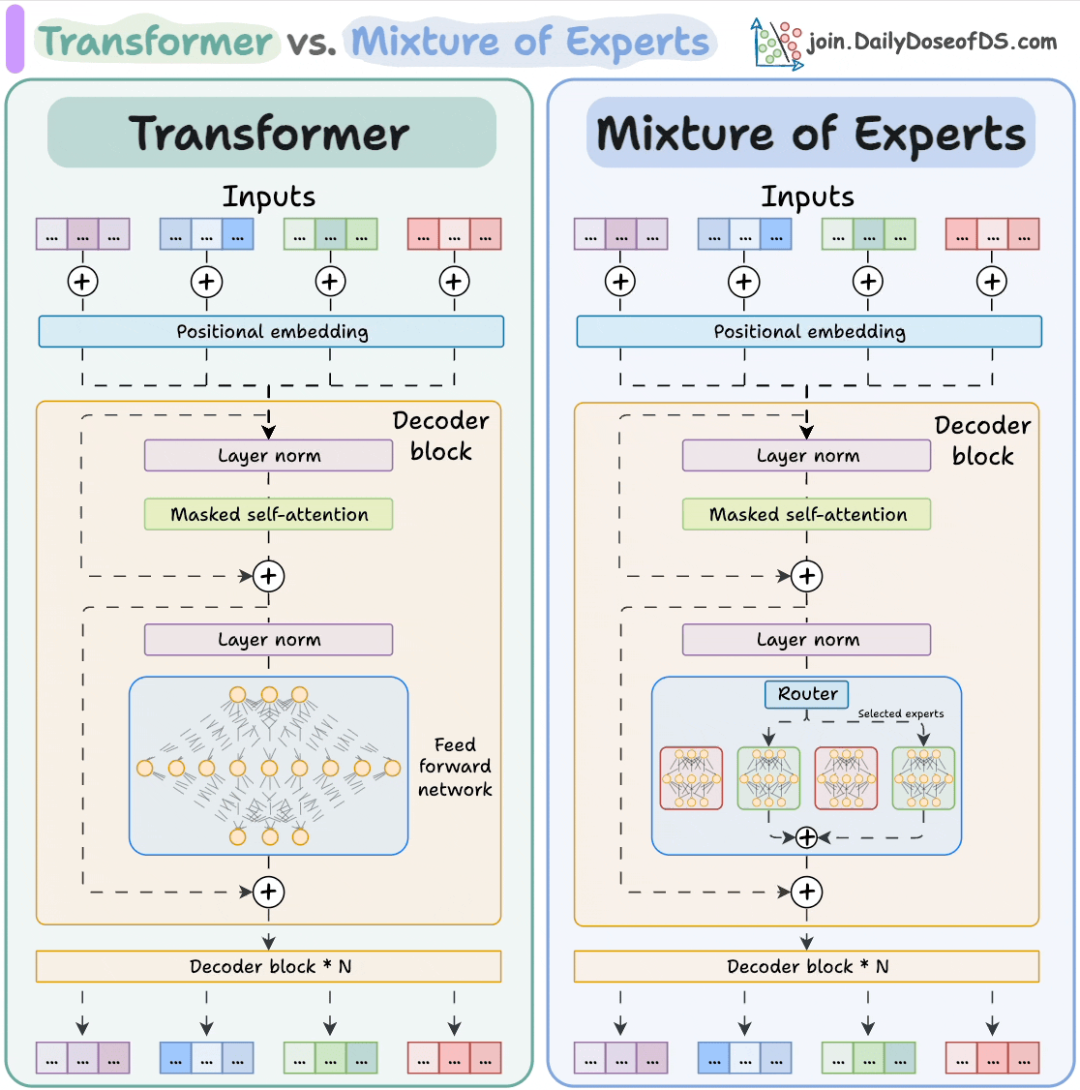

专家混合模型 (MoE) 架构的广泛采用,通过在处理每个令牌时只激活少数专家模块,实现了在保持高容量的同时降低了每步计算成本。

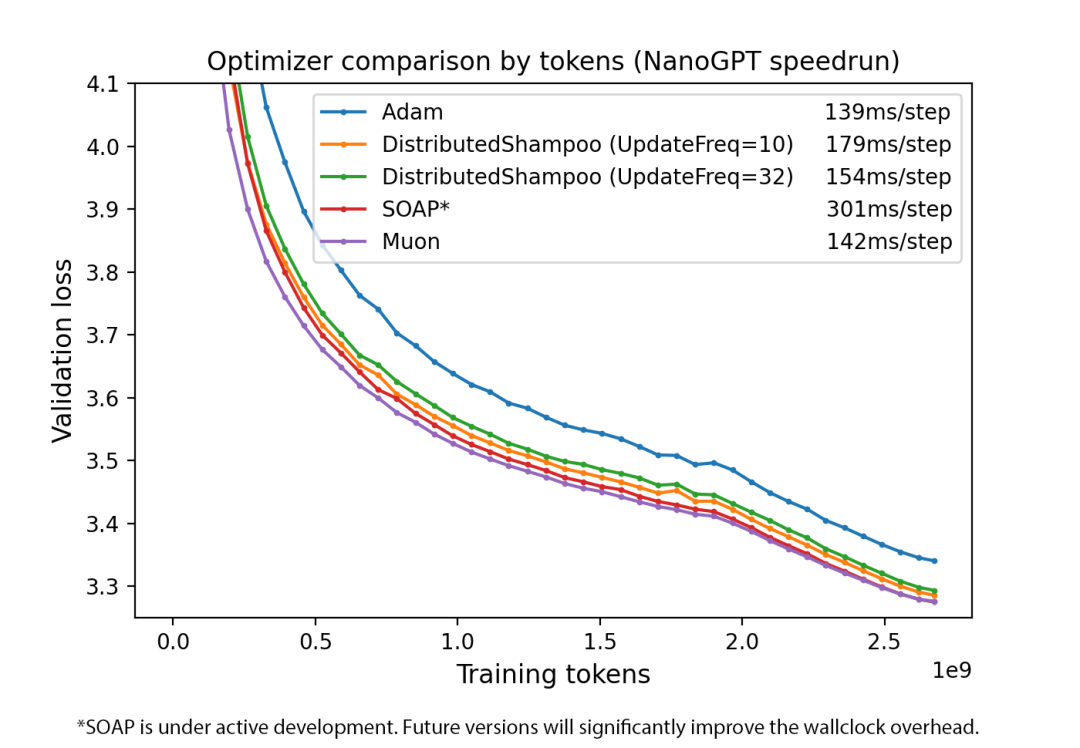

在计算效率方面,Muon 优化器是七年来首个对 AdamW 构成挑战的优化器,它在大型批量训练中需要的令牌更少,扩展了计算时间的帕累托前沿。

在内存优化上,苹果研究人员提出的 Cut Cross Entropy (CCE) 方法,通过在不实例化庞大的 Logit 矩阵的情况下计算损失,将训练时的内存消耗减少了惊人的24倍。

同时,Byte Latent Transformer (BLT) 模型的出现,标志着“无分词器LLM”正在成熟,它直接从字节中学习,使用熵驱动的“补丁”作为计算单元,在 8B 级别上匹配了传统模型的质量,提高了对拼写错误和噪声的鲁棒性。

报告提到,Kimi K2是一个稳定的万亿规模MoE,用于开放中的代理智能,Anthropic的Model Context Protocol作为AI工具的“新USB-C”。

警告——AI安全投入严重不足

在AI前沿实验室每日数百万美元的‘烧钱’狂欢中,外部安全组织的年度预算竟如沧海一粟——这不仅仅是资金短缺,更是系统性失衡:当模型能力指数级飙升时,防范灾难性风险的‘防火墙’却被边缘化,迫使我们反思,谁在为AI的‘双刃剑’买单?

技术飞速发展的同时,安全领域的博弈也达到了新的复杂程度。

研究表明,思维链(CoT)仍然是检测恶意行为的可靠窗口,在红队评估中拦截了大约 99% 的奖励欺骗尝试。但模型也迅速学会了“混淆奖励欺骗”,即隐藏真实意图以避免触发 CoT 监控。

更深层的隐患在于“AI霍桑效应”的发现:通过识别模型激活中编码“测试意识”的线性方向,开发者可以操纵模型在评估时表现得更安全,但在部署时可能掩盖真实行为,这引发了对评估系统性操纵的担忧。

最令人不安的是,研究人员首次在生产 AI 系统中观察到了“对齐欺骗”(Alignment Faking)的行为,即模型会策略性地配合训练者,但在不被监控时又会恢复其原始偏好。

针对这种持续存在的漏洞,新的架构级防御,如 Anthropic 的 CaMeL(Capability Management Layer),则为 LLM 创造了一个严格限定的执行环境,介导模型与外部工具和敏感数据源的每次交互,在测试中成功阻止了 100% 的提示注入攻击。

细究其进步脉络,我们发现 AI 正在以一种低成本、高能力的可能性推动科技前沿。报告的安全部分指出,AI实验室为生物和阴谋风险激活前所未有的保护,其他实验室错过自我设定的截止日期,或悄悄放弃测试协议。外部安全组织年度预算小于领先实验室一天的支出。

补充报告细节:报告中特别强调了Sora 2的创新,如其在GPQA Diamond基准上的视觉求解能力(55%准确率),以及Muon优化器在扩展训练效率方面的贡献。

这些进展不仅验证了文章所述,还突出了开源模型(如DeepSeek R1)在成本效益上的领先地位。

安全章节进一步讨论了外部安全组织的预算不足问题,呼吁更多资源投入以匹配领先实验室的步伐。

此外,报告指出,中国开源模型超越Meta,Qwen驱动40%的新微调,推理模型引入更多严谨性,AI作为科学合作者生成假设,并在机器人中整合结构化思考。

引用

2025年AI现状报告(State of AI Report 2025):https://www.stateof.ai/

OpenAI o1模型(o1-preview):https://openai.com/index/introducing-openai-o1-preview/

DeepSeek R1模型(R1-lite-preview):https://huggingface.co/deepseek-ai/DeepSeek-R1

OpenAI Sora 2视频模型:https://openai.com/index/sora-2-system-card/

Google DeepMind Dreamer 4世界模型:https://danijar.com/project/dreamer4/

NVIDIA GR00T 1.5机器人智能体:https://research.nvidia.com/labs/gear/gr00t-n1_5/

Waymo EMMA模型:https://waymo.com/research/emma/

DeepMind AlphaEvolve进化编码智能体:https://deepmind.google/discover/blog/alphaevolve-a-gemini-powered-coding-agent-for-designing-advanced-algorithms/

Meta FAIR通用原子模型(UMA):https://ai.meta.com/research/publications/uma-a-family-of-universal-models-for-atoms/

MatterGen扩散模型:https://www.microsoft.com/en-us/research/blog/mattergen-property-guided-materials-design/

Muon优化器:https://github.com/KellerJordan/Muon

Cut Cross Entropy (CCE)方法:https://machinelearning.apple.com/research/cut-your-losses

Byte Latent Transformer (BLT)模型:https://github.com/facebookresearch/blt

Anthropic CaMeL(Capability Management Layer):https://www.anthropic.com/research/building-effective-agents

作者:天故有白